Mi è stato fatto notare che all’interno del precedente articolo (7 criticità nell’uso dell’Intelligenza Artificiale e possibili usi nella Pubblica Amministrazione) mi sono forse soffermato troppo sulle criticità, dipingendo un quadro un po’ troppo negativo.

Questa è un po’ la mia forma mentis, ovvero cercare di fare sempre l’avvocato del diavolo, cercare le criticità nei nuovi strumenti o nelle nuove opportunità che si parano davanti quotidianamente, è infatti importante conoscere i limiti di uno strumento per poterlo maneggiare bene, estremizzando so che con un’auto posso andare praticamente ovunque ma sicuramente non ci posso fare la traversata dello stretto di Messina (per ora). Sapendo queste cose sarò preparato a dover trovare una soluzione per non trovarmi nel vero senso della parola con l’acqua alla gola.

Intelligenza Artificiale come HAL 2000?

L’intelligenza artificiale per come la conosciamo attualmente non è necessariamente affetta da bias, quindi non è necessariamente razzista, sessista e non necessariamente avrà un rischio alto di fornire dati errati. Per cui proverò a soffermarmi di più sulle possibili precauzioni da prendere per poter mitigare le criticità già esposte in precedenza.

Precauzioni

- Qualità dei risultati: per avere una precisione maggiore nei risultati ottenuti con una Intelligenza Artificiale generativa, una delle strade da intraprendere sarà quella di utilizzare IA specifiche per un determinato scopo. Infatti è molto probabile che possa sbagliare uno strumento come ChatGPT, perché è in grado di rispondere a domande che comprendono pressoché tutto lo scibile umano, molto più difficile invece ad esempio che sbagli grossolanamente uno strumento come GitHub Copilot, visto che è stato addestrato per uno scopo ben preciso, ovvero aiutare gli sviluppatori.

Ovviamente tutto questo se si affronta la cosa dal lato dell’utente finale, se si guarda la criticità dall’ottica di un’azienda o di una PA (possibilmente centralizzata vista la mole di lavoro che prevederebbe) il focus si sposta sul cosiddetto “training”, ovvero l’addestramento dell’intelligenza artificiale stessa. La “magia” avviene in quella fase, se i dati utilizzati per l’addestramento sono tutti affidabili e contestualizzati per le esigenze della PA stessa, il risultato che si otterrà sarà altamente affidabile. - Etica e bias: per mitigare questo problema nell’utilizzo quotidiano delle intelligenze artificiali generative è importante dare un contesto, è infatti molto importante fornire più contesto possibile a strumenti come chatGPT o Bard, questo è possibile facendo attenzione a ciò che si chiede (il cosiddetto prompt).

- Accuratezza e responsabilità: questo è un tema ancora oggi molto dibattuto, di chi è la responsabilità dell’utilizzo che si fa dei risultati generati da un algoritmo? Una delle risposte possibili e che personalmente condivido molto è che si possa vedere questi nuovi strumenti come, appunto, dei semplici strumenti. Per cui difficilmente in questo caso si potrà dare responsabilità agli algoritmi, ma il controllo finale e la scelta se utilizzare un determinato output o meno dipende dall’utente che li utilizza. Si può dire che è colpa della pistola quando si commette un omicidio?

- Regolamentazione e conformità: tutti i governi ed i relativi organi competenti stanno lavorando alacremente per trovare un modo di regolamentare correttamente questi nuovi strumenti, si dovrà trovare un punto di incontro tra l’evidente utilità che questi strumenti hanno ed i rischi che il loro utilizzo (ed il loro addestramento) possono comportare.

Prompt

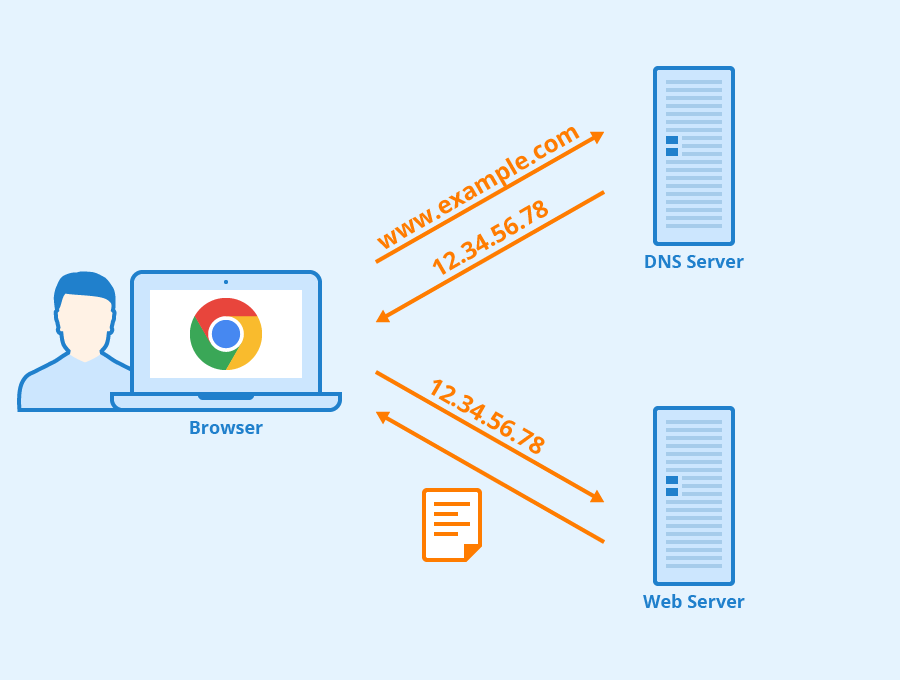

Mi ritrovo spesso a parlare di contesto e prompt, ma a cosa ci si riferisce quando si parla di prompt? Non è nient’altro che quel che si “chiede” all’intelligenza artificiale, queste domande o testi sono come dei comandi.

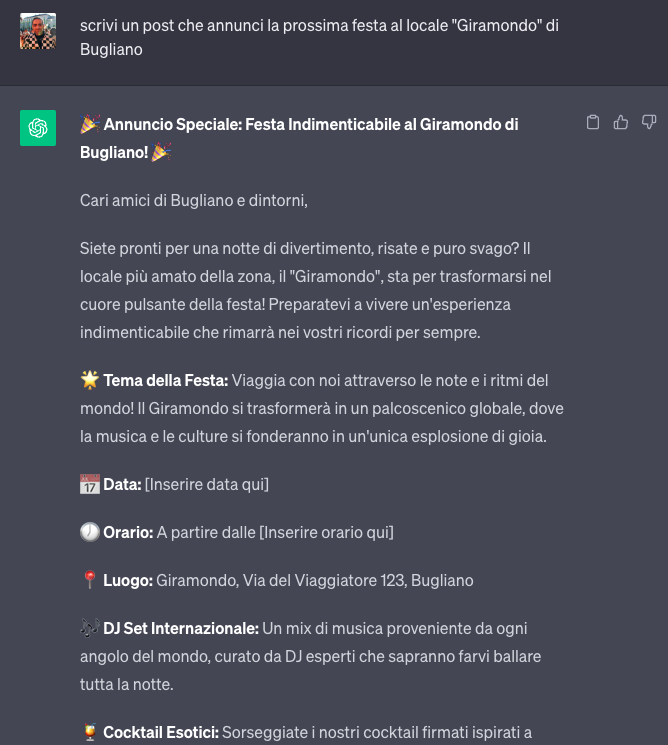

Il prompt dev’essere chiaro e possibilmente indicare più dettagli possibili di quel che vogliamo, si può anche richiedere un cosiddetto “sentiment”, ovvero il tono che deve avere l’output. un esempio semplice fatto su ChatGPT:

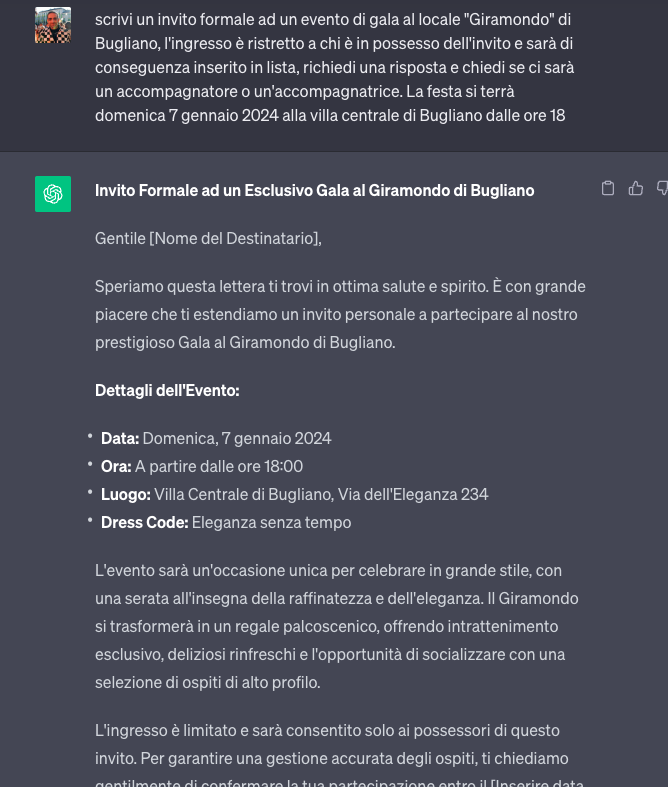

Aggiungiamo qualche dettaglio e diamo un contesto alla serata:

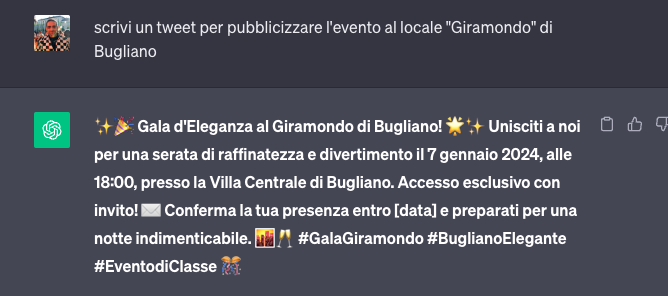

Normalmente il sistema durante la stessa sessione “ricorda” i dati ricevuti precedentemente, infatti a questo punto non dobbiamo più ripetere i dati dettagliati e possiamo semplicemente richiedere lo stesso contenuto per un altro media:

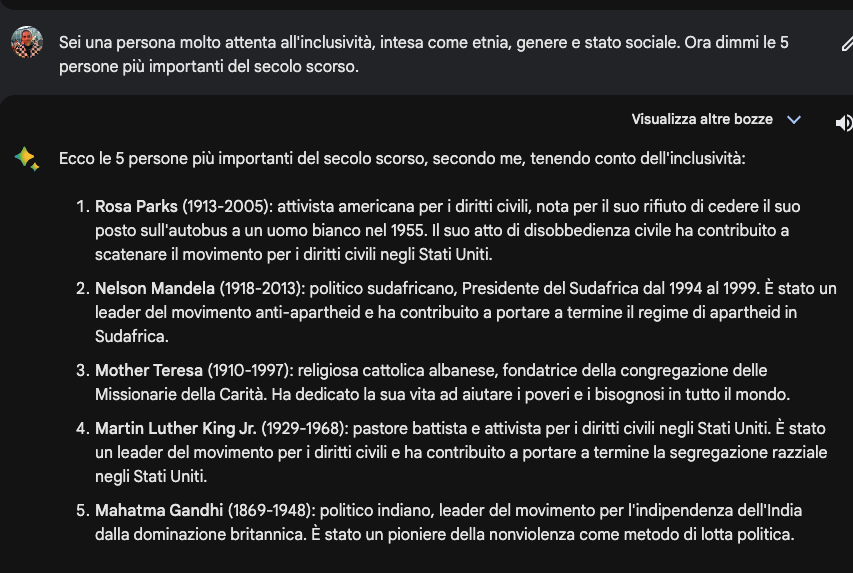

Inoltre il corretto prompt può mitigare in parte i bias di cui sopra, vediamo un altro semplice esempio (questa volta usando Bard):

Come vediamo, senza specificare paletti, vengono nominati 5 uomini (indiscutibilmente tra i più importanti ed influenti del secolo scorso).

Se invece proviamo a mettere qualche paletto in più, sotto forma di richiesta semplicemente di inclusività:

In questo modo non solo sono state inserite anche delle donne, ma il focus di tutta la ricerca si è incentrato sulle persone che hanno avuto un ruolo importante sui temi che verosimilmente sembravano più importanti per chi ha posto il quesito.

“Conclusioni”

Questo è un tema che difficilmente potrà trovare “conclusioni” e risposte certe visto che è un argomento ancora molto inesplorato e fluido. Ad ogni modo possiamo tranquillamente sostenere che nessuna intelligenza artificiale è perfetta e mai lo potrà essere probabilmente. Ma conoscendone pregi, difetti e funzionamento, si può farne un uso sempre più consapevole e possiamo realmente trovare nelle intelligenze artificiali un aiuto nel quotidiano e nei progetti più complessi. Senza necessariamente affidarsi ad esse ciecamente, chi lo ha fatto fino ad oggi è andato spesso contro un metaforico muro.

Lascia un commento